快速开始

SophNet兼容了OpenAI Python SDK,帮助开发者能够高效且便捷地集成和调用API,只需几行代码即可轻松接入大模型能力。

环境准备

准备工作

- 在您的项目下完成API Key创建、启用服务之后,才能调用服务端 API。请确保apikey和您的模型服务在同一个项目下

- 调用 API 时,需要将访问凭证放入请求 Header 中(Authorization:Bearer

API Key)

安装Python库

使用python SDK前需要安装Python库,在终端运行

pip install OpenAIChat Completions(基础模型)

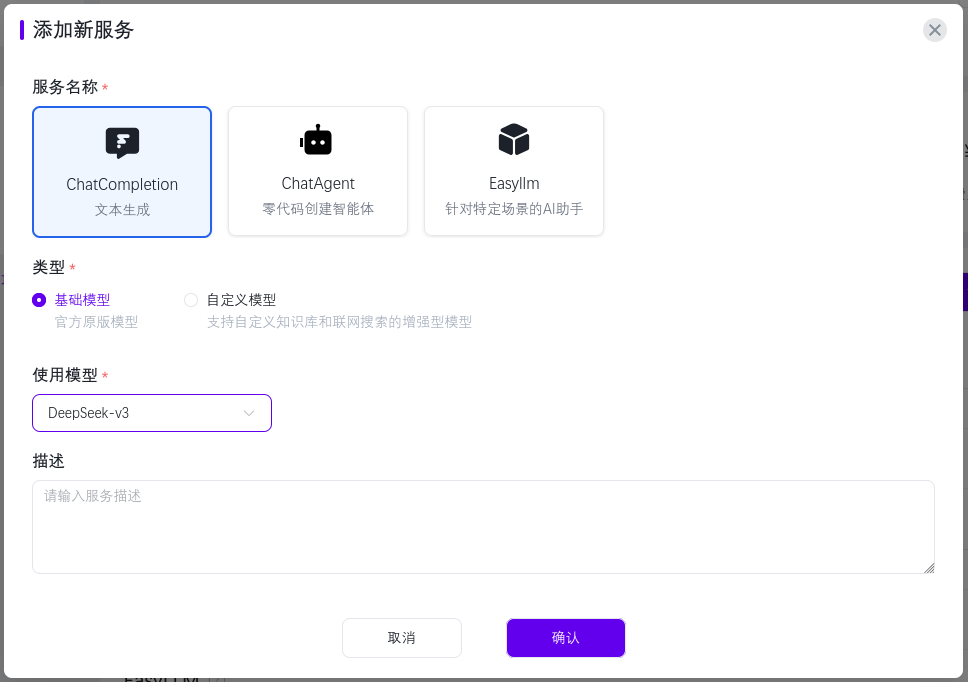

启用Chat Completion服务

- 在项目概览界面,点击添加新服务

- 设置服务名称为ChatCompletion,选择类型为基础模型,设置使用的模型,点击确认

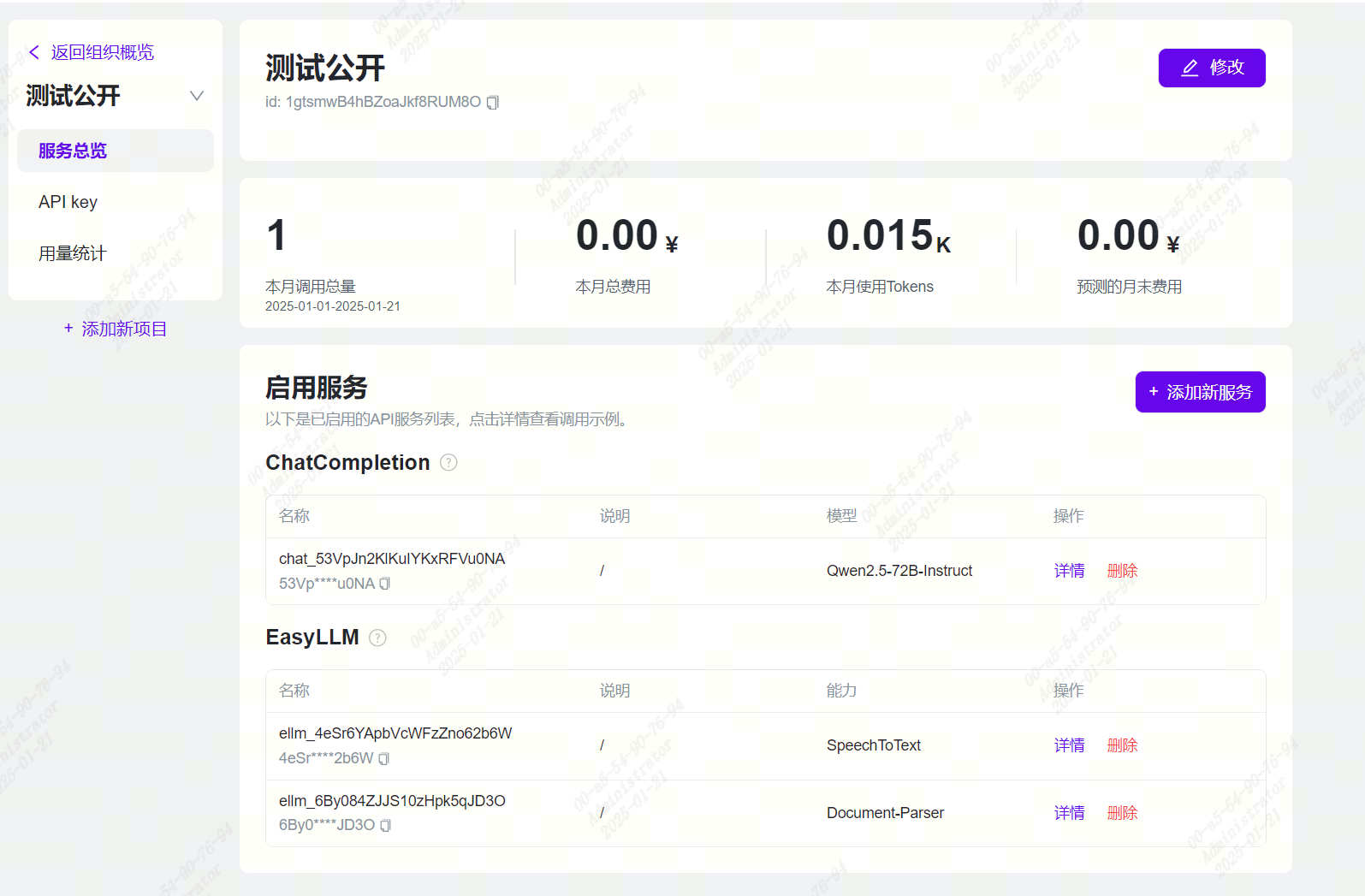

- 添加ChatCompletion服务成功后,可以在启用的服务列表里查看服务信息

- 点击服务详情即可查看调用示例

创建Python应用

- 创建一个名为 chat_quickstart.py 的Python 文件。然后在编辑器或 IDE 中打开它。

- 将 chat_quickstart.py 的内容替换为以下代码。

# 支持兼容OpenAI Python SDK 终端运行:pip install OpenAI

from openai import OpenAI

### 初始化客户端

client = OpenAI(

api_key= "API_KEY",

base_url= "https://www.sophnet.com/api/open-apis"

)

### 调用接口

response = client.chat.completions.create(

model="DeepSeek-v3",

messages=[

{"role": "system", "content": "你是SophNet智能助手"},

{"role": "user", "content": "你可以帮我做些什么"},

]

)

# 打印结果

print(response.choices[0].message.content)- 运行chat_quickstart.py

python chat_quickstart.pyChat Completions(自定义模型)

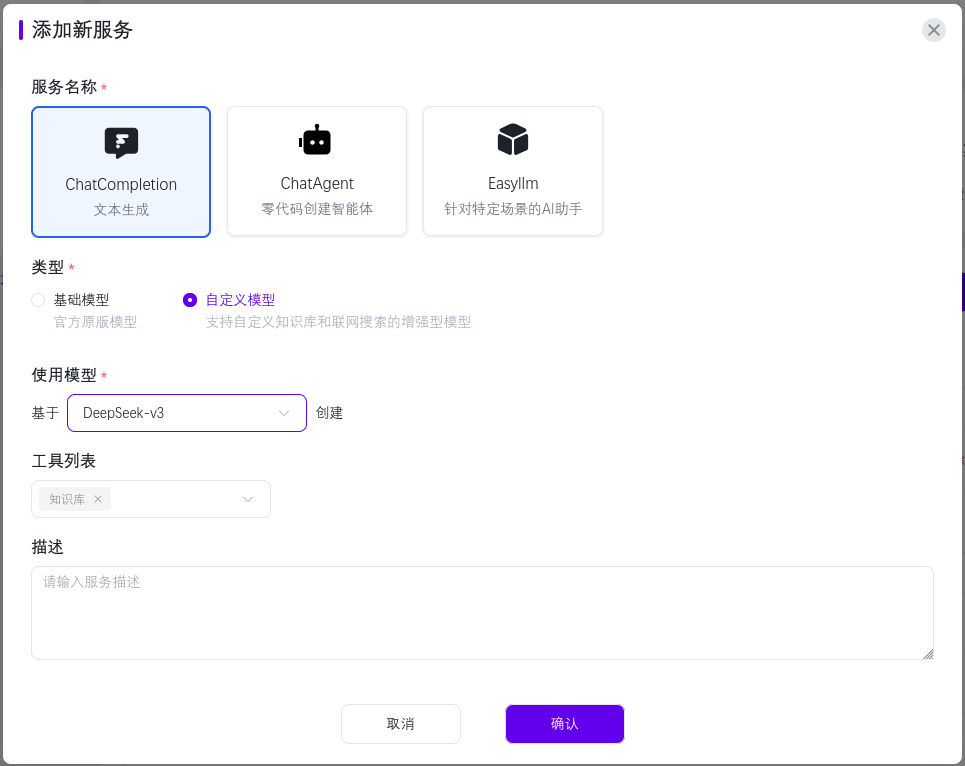

启用Chat Completion服务

- 在项目概览界面,点击添加新服务

- 设置服务名称为ChatCompletion,选择类型为自定义模型,设置使用的模型,点击确认

- 添加ChatCompletion服务成功后,可以在启用的服务列表里查看服务信息

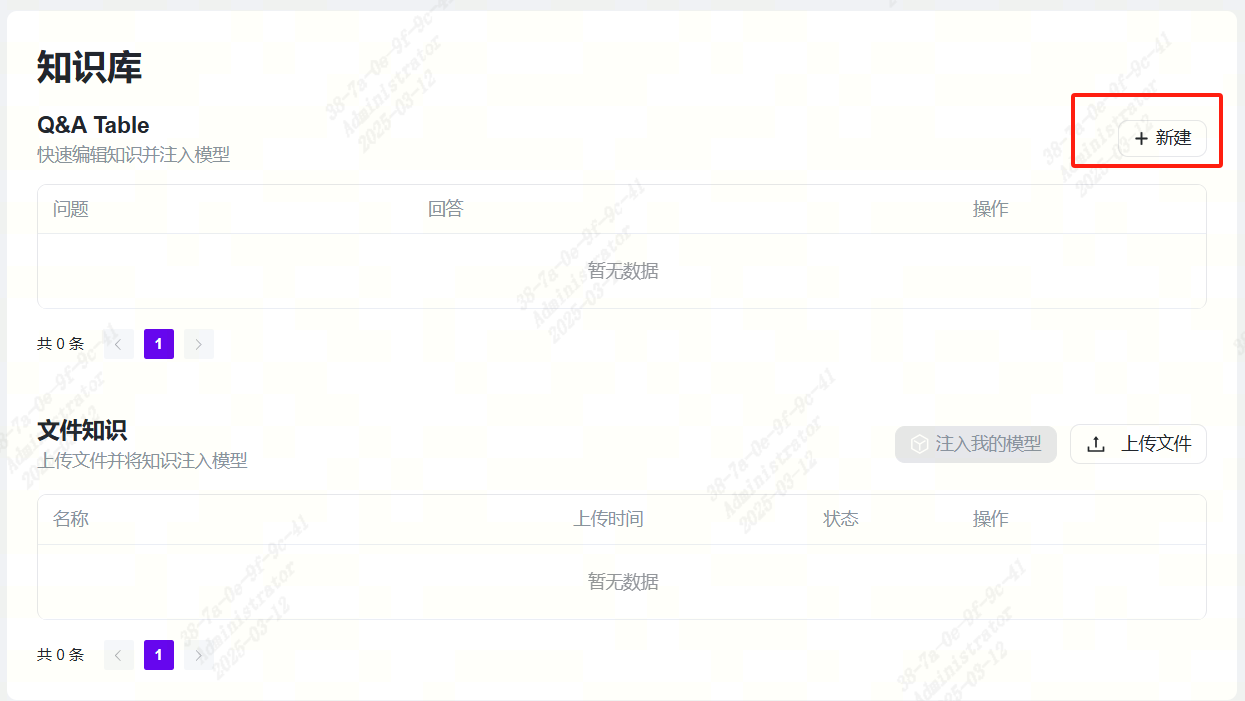

知识注入

SophNet支持Q&A Table和上传知识文档两种方式为模型注入知识

Q&A Table

- 点击带有自定义字样的服务,进入服务详情,点击新建按钮新增Q&A

- 填写问题和回答,点击保存即可注入知识到模型

上传知识文档

- 点击上传文件按钮上传知识文件

- 上传后文件处于未注入状态,点击注入我的模型即可注入知识

- 文件处于已注入状态,代表注入成功

创建Python应用

- 查看调用示例中model值

创建一个名为 chat_quickstart.py 的Python 文件。然后在编辑器或 IDE 中打开它。

将 chat_quickstart.py 的内容替换为以下代码。

a.非流式调用

在非流式调用中,会在最终结果内输出此次回答包含的所有引用来源信息。

# 支持兼容OpenAI Python SDK 终端运行:pip install OpenAI from openai import OpenAI ### 初始化客户端 client = OpenAI( api_key= "API_KEY", base_url= "https://www.sophnet.com/api/open-apis" ) ### 调用接口 response = client.chat.completions.create( model="YOUR_MODEL", messages=[ {"role": "system", "content": "你是SophNet智能助手"}, {"role": "user", "content": "你可以帮我做些什么"}, ] ) # 打印结果 print(response.choices[0].message.content) # 检查是否存在引用 if hasattr(chunk.choices[0], 'refs'): # 打印引用 print(chunk.choices[0].refs)b.流式调用

在流式响应过程中,会实时于存在引用的位置输出引用来源信息,并在finish_reason不为空时输出此次回答包含的所有引用来源信息。

# 支持兼容OpenAI Python SDK 终端运行:pip install OpenAI from openai import OpenAI ### 初始化客户端 client = OpenAI( api_key= "API_KEY", base_url= "https://www.sophnet.com/api/open-apis" ) ### 调用接口 response = client.chat.completions.create( model="YOUR_MODEL", messages=[ {"role": "system", "content": "你是SophNet智能助手"}, {"role": "user", "content": "你可以帮我做些什么"}, ], stream=True ) for chunk in response: if chunk.choices: # 打印结果 print(chunk.choices[0].delta.content) # 检查是否存在引用 if hasattr(chunk.choices[0], 'refs'): # 打印引用 print(chunk.choices[0].refs)运行chat_quickstart.py

python chat_quickstart.py